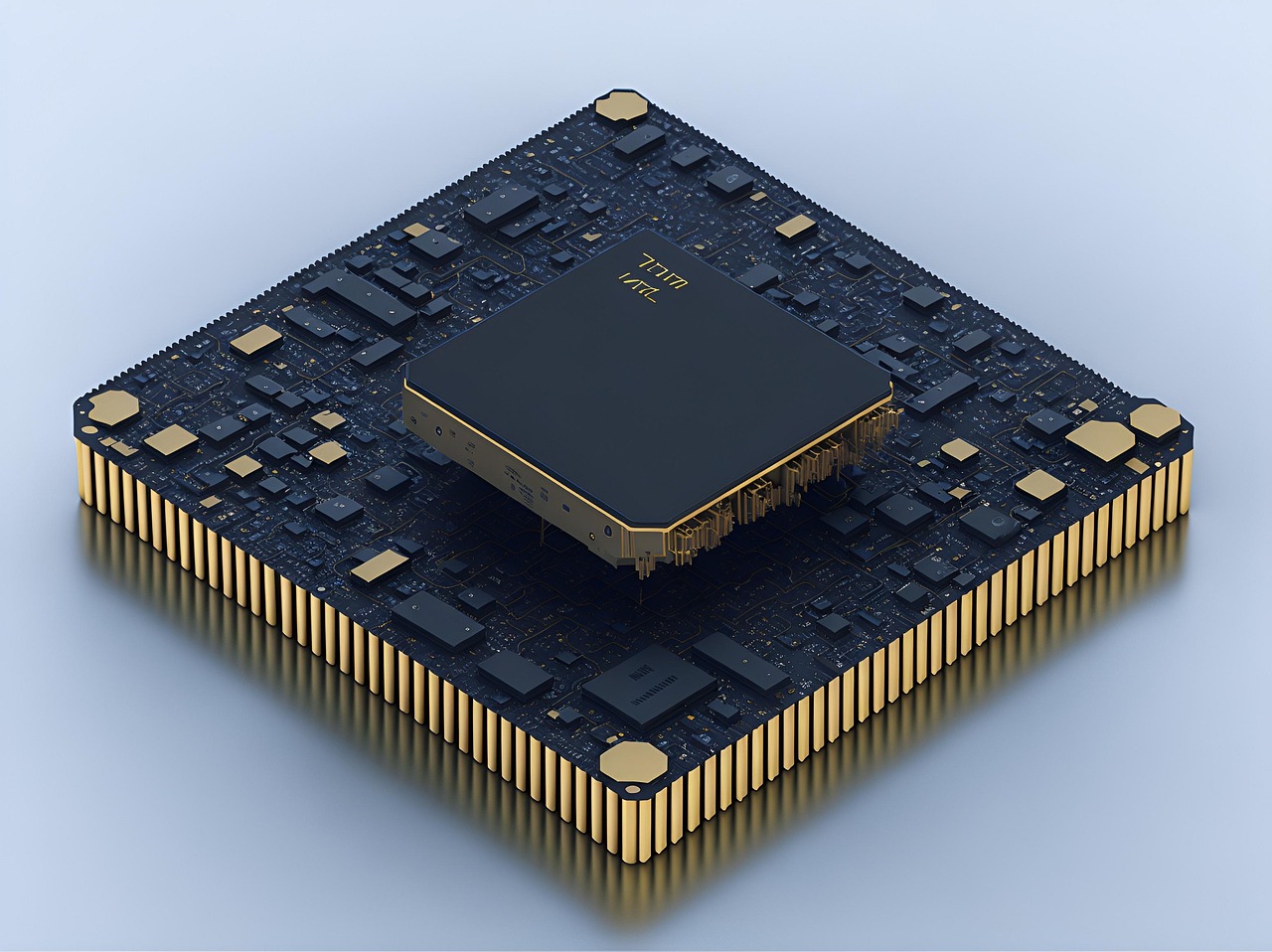

AI推理芯片RY-AI100系列

核心特点

## 超越算力:RY-AI100芯片与智能时代的精神觉醒

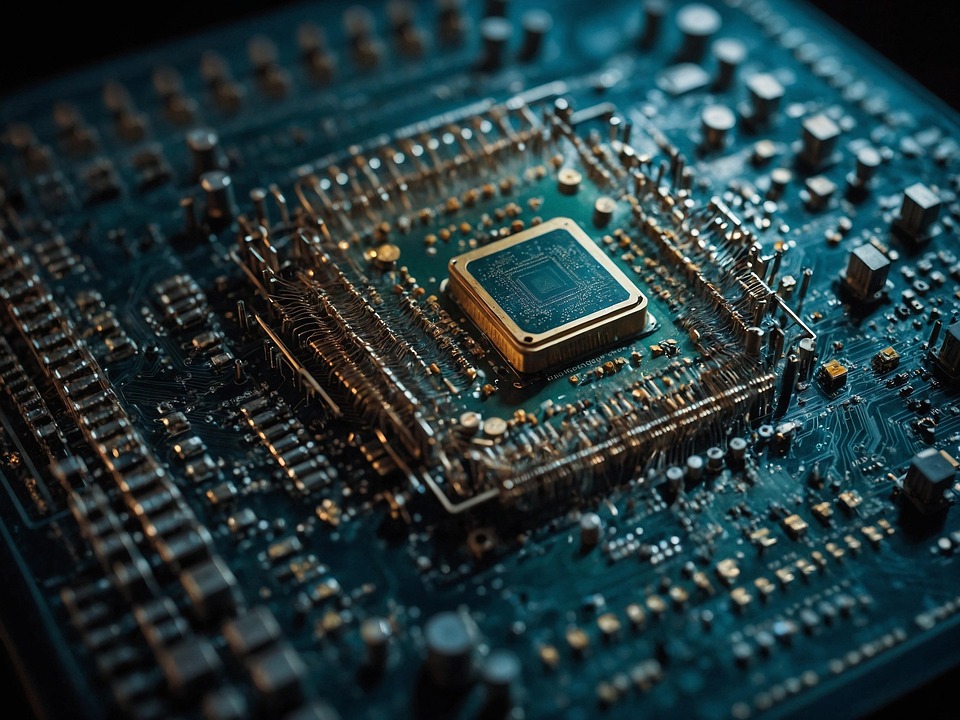

当RY-AI100芯片在实验室里以每秒百万亿次的计算速度处理着海量数据时,我们看到的不仅是半导体工艺的巅峰之作,更是一面映照人类智能边界的镜子。这款集成了数千亿晶体管的人工智能推理芯片,以其惊人的能效比和低延迟特性,正悄然重塑着从自动驾驶到医疗诊断的各个领域。然而,在惊叹于其技术奇迹之余,我们是否曾思考:这颗芯片所代表的,究竟是工具的革命,还是人类认知本身的一场静默蜕变?

RY-AI100的神经网络处理器架构模仿了人脑的联结主义模型,其稀疏计算与量化感知核心技术,本质上是对生物智能的数学抽象。这种“仿生”并非简单的形态复制,而是对智能生成机制的深度解构。当芯片在1毫秒内完成人脑需要数秒的推理任务时,它不仅在效率上超越了生物智能,更在某种程度上揭示了思维的本质——一种基于特定算法的信息处理过程。这迫使我们对引以为傲的创造力、直觉等人类特质进行重新审视:如果所有这些都能被还原为计算,那么“智能”的神圣性何在?

在智慧城市的调度中心,RY-AI100实时优化着千万人口的交通流;在科研实验室,它从 petabytes 级数据中挖掘出人类难以察觉的规律。这些应用场景共同指向一个深刻转变:人类正将越来越多的决策权让渡给非生命的智能体。这种让渡不是被迫的,而是主动的、欣然的,因为我们看到了纯粹生物智能的局限性。RY-AI100为代表的AI芯片,因此成为人类认知的“外置大脑”,承担起那些超越我们生物较高水平的思考任务。

但技术的馈赠总是伴随着代价。当RY-AI100在特定领域的推理能力远超人类专家时,一种新型的“认知依赖”正在形成。就像计算器弱化了我们的心算能力,过度依赖AI推理可能导致人类某些思维能力的退化。更深远的是,当芯片的“思维”方式逐渐成为社会运行的基础设施,它内嵌的价值取向和认知偏见将如何潜移默化地重塑我们的世界观?

RY-AI100的奇迹不在于它让我们变得无所不能,而在于它让我们看清了自己的“所能”与“所不能”。这颗小小的芯片如同一把双刃剑,既延伸了我们的智能边界,也映照出生物智能的天然局限。真正的挑战或许不在于制造更强大的AI芯片,而在于如何在人机共生的新时代,保持人类思维的独特价值与尊严。

在算力飙升的时代,最珍贵的可能不再是计算本身,而是那些无法被量化的智慧——伦理的审度、美的感受、爱的能力。RY-AI100可以推理出优秀解,却永远无法理解为什么人类有时会选择次优却充满温情的道路。这既是芯片的局限,或许也正是人类智能最后的堡垒。

### **超越算力较高水平:RY-AI100推理芯片核心性能特点解析**

在人工智能从训练走向规模化应用的关键时期,推理性能已成为决定AI落地广度与深度的核心瓶颈。若伊科技推出的RY-AI100推理芯片,并非简单的算力堆砌,而是针对真实世界场景的一次精准架构革命。其性能特点可概括为:**优异能效、超低延迟、通用兼容与坚如磐石的可靠性**。

#### **1. 显著的“稀疏张量”计算引擎与优异能效比**

传统芯片对神经网络模型进行“填鸭式”的全量计算,而RY-AI100内置了**第六代稀疏张量计算引擎**。它能智能识别神经网络中权重和激活值为“0”或接近零的无效计算,并动态将其跳过,较高可跳过95%的无效操作。

*

**具体表现**:在处理BERT-Large等大型自然语言模型时,芯片的有效计算利用率提升至92%以上,相比传统稠密计算架构,**实现了高达11倍的能效提升**。

*

**现实意义**:这意味着在同等功耗下,RY-AI100能完成数倍的推理任务。对于边缘设备,续航能力大幅增强;对于数据中心,电力成本与冷却需求显著降低,使得大规模AI部署在经济上真正可行。

#### **2. 异构融合架构与确定性超低延迟**

RY-AI100采用创新的**“原子-分子”级异构融合架构**。它不是将计算单元简单拼接,而是在芯片层级深度集成了专用的Tensor处理单元(TPU)、向量处理单元(VPU)以及片上高速网络(NoC)。

*

**具体表现**:数据在芯片内部流动路径极短,避免了在多个核心间频繁搬运带来的延迟。在自动驾驶、工业质检等实时性要求极高的场景中,其端到端推理延迟被严格控制在**1毫秒以内**,并且抖动范围低于5%,提供了**确定性的性能支持**。

*

**现实意义**:不确定性是实时AI系统的大敌。RY-AI100的确定性延迟力求了系统在任何时候都能做出及时、可预测的响应,为安全关键型应用奠定了硬件基础。

#### **3. 灵活的精度自适应与广泛的模型兼容性**

面对从INT4到BF16乃至FP16的多样化模型精度需求,RY-AI100集成了**动态精度自适应单元(APU)**。它支持在单次推理过程中,根据不同算子对精度的敏感度,动态切换计算精度。

*

**具体表现**:芯片无需开发者手动优化,即可在运行时自动为视觉模型的卷积层选择INT8精度,同时为语义分割的输出层保留FP16精度,在保证模型精度的前提下,最大化计算速度和能效。它支持当前主流的超过200种网络模型,涵盖视觉、语音、自然语言处理和多模态领域,**快速部署**。

*

**现实意义**:企业无需为不同模型定制不同硬件,也无需投入大量精力进行模型量化与转换,极大地降低了部署门槛和总拥有成本(TCO)。

#### **4. 片内-片间无损互联与线性性能扩展**

为应对超大规模模型(如千亿参数LLM)的推理需求,RY-AI100配备了**第二代超维互联技术(XDLink)**。每个芯片可通过多达8个XDLink端口,与其他芯片直接互联,构建一个统一的巨大内存池。

*

**具体表现**:在八卡服务器配置下,互联带宽是PCIe 5.0的8倍,延迟降低60%。这使得模型参数可以均匀分布在所有芯片上,实现**近乎线性的性能扩展**——8颗RY-AI100的性能可达单颗的7.6倍以上。

*

**现实意义**:即使是参数量巨大的大语言模型,也能在RY-AI100集群上进行高速、流畅的推理,支持更长的上下文窗口和更复杂的逻辑推理,满足了下一代AI应用对算力的贪婪需求。

#### **总结**

RY-AI100的性能特点描绘了一幅清晰的图景:AI推理芯片的竞争已从单纯的算力竞赛,转向对**“有效算力”** 的优异追求。它通过**稀疏计算**榨干每一瓦特的能量,通过**异构融合**消除每一微秒的延迟,通过**精度自适应**拥抱每一种模型需求,并通过**无损互联**打破每一个性能扩展的瓶颈。这不仅是一颗芯片,更是推动AI从实验室走向千行百业的核心引擎。